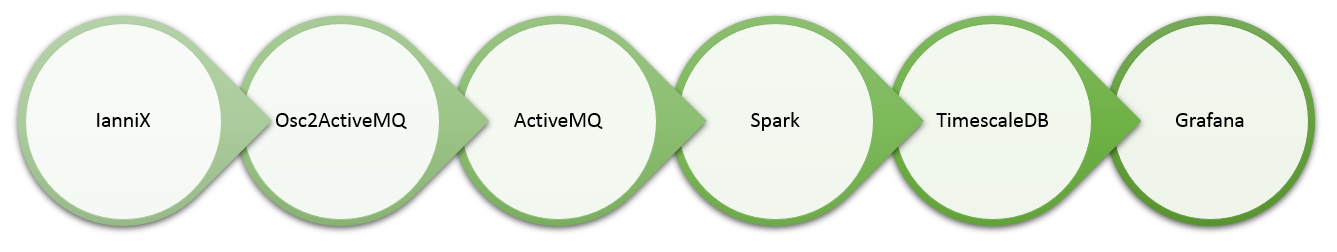

Welcome back to the second part of my series, showcasing a real-time data processing pipeline!

In part 1, I explored visual real-time sensor data simulation, as the entry point into our pipeline.

Now it’s time to find out, how we can get the generated data into Apache ActiveMQ, by transferring it via the OSC protocol.

Apache ActiveMQ™ is the most popular open source, multi-protocol, Java-based messaging server. It supports a variety of Cross Language Clients and Protocols, and therefore makes it an excellent choice for our pipeline.

Get ActiveMQ up and running

I won’t … more